Separata de la revista El Catoblepas • ISSN 1579-3974

Separata de la revista El Catoblepas • ISSN 1579-3974

publicada por Nódulo Materialista • nodulo.org

Separata de la revista El Catoblepas • ISSN 1579-3974

Separata de la revista El Catoblepas • ISSN 1579-3974

publicada por Nódulo Materialista • nodulo.org

El Catoblepas • número 85 • marzo 2009 • página 1

[El pasado día 19 de Febrero de 2009, en el Salón de Grados de la Facultad de Filosofía de la Universidad Complutense de Madrid, se celebró el acto de lectura y defensa de la Tesis Doctoral de Carlos Miguel Madrid Casado, La equivalencia matemática entre Mecánicas Cuánticas y la impredecibilidad en la Teoría del Caos. Dos casos de estudio para el debate realismo-instrumentalismo, realizada bajo la dirección de Andrés Rivadulla (Departamento de Lógica y Filosofía de la Ciencia, Facultad de Filosofía, UCM), ante un tribunal formado por Fernando Bombal (Presidente, Facultad de Matemáticas, UCM), Ana Rioja (Secretario, Facultad de Filosofía, UCM), Luís J. Boya (Facultad de Ciencias, Universidad de Zaragoza), Antonio Diéguez (Facultad de Filosofía y Letras, Universidad de Málaga) y Miguel Ferrero (Facultad de Ciencias, Universidad de Oviedo). Obtuvo la calificación de Sobresaliente cum laude por unanimidad.]

1. Primeras palabras…

1. Buenos días. El objetivo de esta exposición es ofrecer una panorámica, casi casi telegráfica, del contenido de la tesis. Para ello, antes de nada, me gustaría que echáramos un vistazo a la estructura general de la misma, por cuanto nos va a mostrar, por así decir, cuál es la melodía...

2. La tesis se abre con una aproximación preliminar al debate sobre el realismo científico, dado que esta discusión va a servir de marco a toda la tesis. A continuación, se procede a analizar un primer caso de estudio («la equivalencia matemática entre Mecánicas Cuánticas»), a partir del cual se construye un argumento contra el realismo científico. Después, se analiza un segundo caso de estudio («la impredecibilidad en la Teoría del Caos»), a partir del cual se formula un argumento contra el antirrealismo, contra el instrumentalismo. Finalmente, la tesis concluye, por así decirlo, tirando de ciencia media, dilucidando las perspectivas de futuro del realismo científico.

2. Realismo(s) científico(s)

1. Comencemos, pues, por el principio. Es necesario ofrecer, a manera de preliminar, un sistema de referencia común a toda la tesis, para poder empezar a funcionar. Nuestro sistema de coordenadas está relacionado con el tema del realismo científico, tópico que centra el debate actual en filosofía de la ciencia. El objetivo es atacar lo que convengo en llamar el «Mito del Realismo Científico». Dicho de otra manera: no existe algo así como el Realismo Científico, con mayúscula; sino que lo que efectivamente existen son realismos científicos, con minúscula. No hay unicidad. En otras palabras, cuando un filósofo de la ciencia o un científico reclaman para su particular teoría de la ciencia el calificativo de realista, no están queriendo decir nada, a no ser que especifiquen muy bien en qué consiste su realismo, cuáles son sus tesis.

2. Por nuestra parte, proponemos clasificar las tesis gnoseológicas del realismo en dos grandes grupos. Por un lado, las tesis de rango ontológico, que tendrían que ver con la realidad que cabe atribuir a la ciencia y sus constructos. Por otro lado, las de rango epistemológico, que más bien tendrían que ver con la verdad atribuible a las construcciones científicas.

Dentro de las tesis ontológicas, siguiendo la literatura, distingo tres fundamentales: el realismo de entidades («la mayoría de las entidades científicas –por ejemplo, los átomos o el electrón– poseen referente, es decir, son reales, existen»), el realismo de teorías («los estados y los procesos, descritos por teorías científicas, que acontecen a esas entidades son, con excepciones, reales») y el realismo progresivo («el progreso científico es un hecho»). Por oposición, nos encontraríamos con las tesis ontológicas del antirrealismo: el antirrealismo de entidades, de teorías y de progreso.

Dentro de las tesis epistemológicas diferencio cinco: el realismo adecuacionista (que se acoge a la teoría de la verdad como correspondencia), el realismo no adecuacionista (que se acoge a otras teorías de la verdad), el antirrealismo pragmatista, el antirrealismo coherentista y, por último, el antirrealismo relativista (que defendería que elegimos entre teorías científicas rivales o alternativas condicionados por nuestro contexto sociocultural y no en razón de su verdad, éxito o coherencia).

3. Interesa señalar, antes de pasar a otra cosa, que entre las tesis ontológicas del realismo median relaciones muy férreas. Prácticamente, podríamos decir, de consecuencia lógica. Por ejemplo: el realismo de teorías implica, correctamente entendido, el realismo de entidades. En efecto, si se cree en la realidad de los estados y procesos descritos por teorías científicas, hay que creer también en la realidad de las entidades teóricas y observacionales que involucran. Por oposición, por modus tollens, el antirrealismo de entidades implica el antirrealismo de teorías, dado que las entidades aparecen contenidas dentro de las teorías. Sin embargo, este nítido antagonismo se diluye cuando tomamos en consideración las tesis epistemológicas. En efecto, el realismo adecuacionista no sólo puede ser conculcado desde posiciones antirrealistas (pragmatistas, coherentistas o relativistas), sino también desde un realismo científico no adecuacionista.

3. Caso de Estudio I. La equivalencia entre Mecánicas Cuánticas

1. Con este sistema de conceptos que he forjado (realismo de entidades, de teorías, de progreso, &c.), estamos en condiciones de abordar nuestro primer caso de estudio: la equivalencia matemática entre la Mecánica Matricial y la Mecánica Ondulatoria (1925-1932).

2. Si realizamos un análisis del enunciado titular, lo primero que llama la atención es el término «equivalencia matemática». Es decir, antes de ponernos en marcha y analizar históricamente este episodio, necesitamos realizar un análisis filosófico de la noción de equivalencia interteórica en ciencia y, más concretamente, en física. Como es habitual, distingo dos nociones básicas de equivalencia: la equivalencia formal (a nivel teórico) y la equivalencia empírica (a nivel práctico). La equivalencia formal entre dos teorías físicas implica que ambas van a poseer las mismas consecuencias observables, esto es, que ambas van a ser empíricamente equivalentes. Ahora bien, la equivalencia empírica no tiene por qué implicar la equivalencia formal. Así es: la astronomía newtoniana y la astronomía kepleriana salvaban los mismos fenómenos y, sin embargo, esta última carecía del añadido dinámico de que constaba la primera (no había fuerzas).

A su vez, y esto es bastante original, propongo distinguir dos modulaciones dentro de la equivalencia formal, que habitualmente aparecen confundidas en la literatura al uso. La equivalencia formal se desdobla naturalmente en dos. Por una parte, la noción de equivalencia lógica, que captura la idea de traducción entre dos teorías (el caso paradigmático serían las Mecánicas de Lagrange y Hamilton). Por otra parte, la noción de equivalencia matemática, que hace referencia a que los espacios métricos subyacentes que cualquier teoría física contiene –son el aparato matemático mínimo para poder medir– sean isomorfos e isométricos (el paradigma serían, como veremos más adelante, las Mecánicas Matricial y Ondulatoria). Pero, ¿qué relaciones guardan la equivalencia lógica y la equivalencia matemática? La equivalencia lógica implica la equivalencia matemática, dado que si una teoría no es más que la traducción de otra, los espacios métricos subyacentes van a ser trivialmente isométricos por el isomorfismo identidad. En cambio, atención, la equivalencia matemática no implica, en general, la equivalencia lógica, pese a que suela afirmarse y constituya un lugar común. El contraejemplo nos lo proporciona nuestro propio caso de estudio. Por ejemplo, la sentencia que afirma que el valor de la función de onda en un punto determinado del espacio euclídeo es tanto, resulta intraducible a la Mecánica de Matrices, por cuanto las matrices no poseen al espacio euclídeo como dominio (precisamente, para evitar esto, Von Neumann hubo de restringirse a las clases de equivalencia de funciones de Lebesgue, que ya no están definidas sobre puntos espaciales sino sobre intervalos). En suma, la Mecánica Matricial y la Mecánica Ondulatoria son matemática pero no lógicamente equivalentes.

Werner Heisenberg

3. Con todo esto en mente, viajemos en el tiempo hacia el pasado, más exactamente a la primavera de 1926, cuando dos soles brillaban sobre la tierra cuántica. En Gotinga y Copenhague, la Mecánica Matricial de Heisenberg-Born-Jordan (1925) conllevaba un enfoque algebraico, que casaba con una concepción discreta y corpuscular del mundo atómico. En el resto de Europa, la Mecánica Ondulatoria de Schrödinger (1926) apostaba por un enfoque analítico y una visión continua del microcosmos basada en las ondas de materia. Y, sin embargo, pese a las grandes diferencias sintácticas, semánticas y pragmáticas que las separaban, ambas Mecánicas Cuánticas –a partir de ahora denotadas, por comodidad, MM y MO– arrojaban idénticas predicciones observables, es decir, eran empíricamente equivalentes. ¿Por qué? La idea feliz que tuvieron casi simultáneamente Schrödinger, Eckart y Pauli fue pensar que la explicación de la equivalencia empírica estaba en que MM y MO tenían que ser también matemáticamente equivalentes.

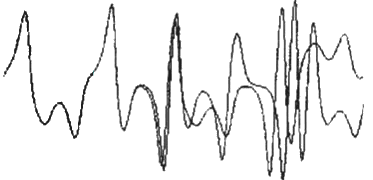

Página de un cuaderno de notas de Erwin Schrödinger

Las «pruebas» de equivalencia de 1926 han levantado desde siempre una gran polémica. Las posiciones al respecto van desde los «negacionistas» (que a día de hoy aún siguen rechazando que MM y MO sean equivalentes) a los que, reconociendo la equivalencia, se querellan por la autoría (dándosela unos a Schrödinger, Eckart o Pauli, otros a Dirac, y una minoría, dentro de la que nos alineamos, a Von Neumann). A nuestro entender, Schrödinger, Eckart y Pauli prueban únicamente –y con gran dificultad– que MO implica MM (MO→MM), o lo que es lo mismo, que MO está contenida en MM. Pero no prueban que MM implique MO (MM→MO), esto es, que MM también esté contenida en MO. Y la importancia gnoseológica de esta carencia radica en que resultaría posible pensar que MM es más general que MO, al contenerla. De otro modo, la superioridad del método matricial frente al método ondulatorio quedaba en juego.

Para justificar nuestra tesis, se nos ocurre ofrecer dos clases de razones. Primero, una razón de orden científico o, si se quiere, de primer grado: a partir de los operadores y las funciones de onda, Schrödinger, Eckart y Pauli son capaces de construir las matrices; pero fracasan a la hora de recuperar, desde las matrices de Heisenberg-Born-Jordan, los operadores y las funciones de onda, por cuestiones técnicas (no toda matriz de Heisenberg era una matriz de Wintner y el problema de los momentos de Schrödinger está indeterminado). Segundo, una razón de orden filosófico o, si se prefiere, de segundo grado: MO presenta una estructura de dos niveles (estados / observables), pero MM no (sólo hay matrices); y si las matrices se hacen corresponder a los operadores, ¿qué hacerle corresponder a las funciones de onda?

Es Dirac quien con su Teoría de las Transformaciones (1927) nos deja a un paso de la equivalencia. Dirac prueba que MM y MO no son sino dos representaciones o imágenes del álgebra no-conmutativa de los q-numbers (queer-numbers). Existen múltiples representaciones, pero ¿son todas equivalentes entre sí? ¿Lo son, en particular, MM y MO? Dirac, al igual que Hermann Weyl, lo conjetura; pero son Marshall Stone y, en rigor, Von Neumann quienes lo demuestran en 1931: todas las soluciones de PQ – QP = h / 2πi son, esencialmente, idénticas. Además, Dirac forja, en 1930, la distinción estados/observables (implícita en MO), y descubre que los autovectores de las matrices juegan el papel de los estados en MM, a la manera que las autofunciones de los operadores de onda lo hacían en MO. Sin embargo, Dirac no logra unificar de modo consistente las estructuras matemáticas de MM y MO sin recurrir a la ficción matemática conocida desde entonces como función delta de Dirac, que tardaría varias décadas en ser formalizada (Schwartz, Gelfand, Arno Bohm).

Llegamos, pues, a 1932. Año en que Von Neumann resuelve definitivamente la cuestión de la equivalencia y la unificación de MM y MO. Su Teorema de Equivalencia demuestra que MM –centrada en matrices discretas y sumas– y MO –centrada en funciones continuas e integrales– no son sino dos cálculos de operadores –la estructura de los observables– algebraicamente isomorfos (Teorema de Stone-Von Neumann) sobre dos espacios de Hilbert –la estructura de los estados– topológicamente isomorfos e isométicos (Teorema de Fischer-Riesz). Gracias a Von Neumann, la estructura matemática de la Mecánica Cuántica es solidaria de la del espacio de Hilbert.

4. Vayamos de vuelta de la filosofía de la ciencia. A partir de nuestro caso de estudio vamos a construir un argumento contra el realismo científico. Pero, ojo, no contra cualquier variedad de realismo científico (lo que sería enredarse otra vez en el mito del realismo), sino contra una variedad de realismo científico de gran pujanza a día de hoy en el ámbito de la filosofía internacional de la ciencia. Nos referimos al realismo estructural, propuesto por John Worrall hace exactamente veinte años y defendido a inicios del siglo XXI por Steven French y James Ladyman, entre otros.

El realismo estructural concibe la estructura matemática de nuestras teorías científicas como una representación verdadera de las relaciones entre las entidades (observables e inobservables) de la Naturaleza. Los modelos teóricos representan o copian la propia estructura del Mundo. Los realistas estructurales sostienen, pues, que las estructuras matemáticas de la física capturan la estructura de la Realidad. La prueba estaría en que las teorías nuevas retienen la estructura matemática de las teorías antiguas, como manifiesta la existencia de casos límite en física. Empleando unas archiconocidas palabras de Worrall: «si las ecuaciones siguen siendo válidas, las relaciones siguen siendo reales». A través del cambio científico, se guardaría una continuidad matemática, en la estructura (forma), aunque no necesariamente en la ontología (contenido).

Ahora bien, ¿qué quieren decir los realistas estructurales cuando invocan el término «representación»? ¿Cuándo un modelo M «representa» un sistema real R? La respuesta está, para los realistas estructurales, en las teorías matemáticas de la representación científica. Una primera propuesta sería que los modelos representan cuando son isomorfos a los sistemas reales (Black, Van Fraassen, French, Ladyman, Da Costa). Una segunda propuesta es que los modelos representan cuando son similares (Hesse, Giere, Teller). Y una tercera es que los modelos representan cuando son homomorfos (Mundy, Bartels, Otavio Bueno).

Nuestro propósito es construir un argumento por reducción al absurdo contra el realismo estructural a partir de nuestro caso de estudio. Supongamos por hipótesis que los modelos matemáticos MM y MO son, respectivamente, isomorfos a las estructuras de los sistemas reales X e Y que aspiran a representar. En principio, si la relación entre modelo y realidad es de isomorfismo, las estructuras de X e Y deben ser también isomorfas, dado que MM y MO lo son (Teorema de Equivalencia de Von Neumann) y la composición de isomorfismos es isomorfismo (si X es isomorfo a MM, MM y MO son isomorfos y MO es isomorfo a Y, entonces X e Y son isomorfos). Ahora bien, realmente, ¿son la estructura de X y la estructura de Y isomorfas?

Si lo fueran, deberían tener la misma cardinalidad, como es matemáticamente bien conocido. Pero esto no es, ni mucho menos, así. La estructura de X es discreta, dado que el dominio de MM son los números naturales (lo que se asociaba a una concepción corpuscular del microcosmos). En cambio, como estudiamos, la estructura de Y es continua, dado que el dominio de MO son los números reales (lo que se asociaba con una concepción ondulatoria del microcosmos). MM y MO nos dibujan dos estructuras de la realidad no isomorfas. Resumiendo: MM y MO son matemática y empíricamente equivalentes, pero estructural y ontológicamente incompatibles. Contradicción.

Mi argumento funciona tanto contra los realistas estructurales que aceptan los compromisos ontológicos (la estructura es inseparable de la ontología y, por tanto, la contradicción es partículas versus ondas) como contra aquéllos, los más, que los rechazan (porque, aunque sostengan que el realismo sobre estructuras es disociable del realismo ontológico, han de reconocer la contradicción estructural discreto versus continuo).

¿Cuáles son las posibles salidas al argumento para el realista estructural? Sin duda, la principal consiste en relajar la relación entre modelos y fenómenos. Ahora, cambiar isomorfismo por similaridad no soluciona mucho: X e Y siguen siendo profunda y metafísicamente disimilares (discontinuo vs. continuo, &c.). Y si la relación teoría→mundo se caracteriza empleando homomorfismos, el realista estructural tiene muy difícil legitimar su inferencia realista mundo→teoría («la teoría captura la estructura del mundo»), por cuanto la noción de homomorfismo es realmente débil y no garantiza una correspondencia biunívoca entre la teoría y el mundo. El realista estructural precisa de una relación de representación fuerte, como es la de isomorfismo, para salvar su realismo adecuacionista.

A modo de conclusión provisional, que recogeremos al final de la tesis, afirmamos que la noción de representación es la cruz del realismo estructural y, en general, de la mayoría de realismos científicos. Haríamos bien en restringir su uso a contextos puramente mesocósmicos, en los cuales nunca nos falta la propiedad de enfrentabilidad entre la fuente y el objeto de la representación. Abusar del término, empleándolo en contextos microcósmicos o incluso cósmicos, supone olvidar que, por ejemplo, no somos capaces de percibir el electrón segregadamente de su representación, es decir, de la teoría cuántica, que es juez y parte de nuestro conocimiento de la categoría atómica, con lo que carece de sentido concebir esta última como una representación o retrato del universo a escala atómica. Pero, atención, ¿es posible un realismo científico que renuncie al fantasma de la representación? Continuará…

4. Caso de Estudio II. La impredecibilidad en la Teoría del Caos

1. De nuevo, como punto de arranque, dirijamos nuestra mirada al enunciado titular del caso de estudio: «la impredecibilidad en la Teoría del Caos». Lo primero que llama la atención es el término «impredecibilidad», que en el ámbito de la Teoría del Caos aparece siempre asociado al de «determinismo». Antes de analizar históricamente este caso de estudio, necesitamos analizar filosóficamente esa pareja de conceptos. Hay que estudiar el binomio determinismo/predecibilidad.

2. Frente a los que confunden el determinismo con la predecibilidad (Popper, Prigogine y sus epígonos), nos alineamos con René Thom o John Earman, dentro de la tradición escolástica que pasa por Luis de Molina o Benito de Espinosa que los diferencia. El determinismo es una noción ontológica, porque refiere a la clase de legalidad que opera en el mundo. Por el contrario, la predecibilidad es una noción epistemológica, por cuanto sólo remite a la capacidad de computabilidad numérica de nuestras teorías. De otra manera: el mundo puede ser determinista y nosotros no conocer su determinación, no ser capaces de predecirlo. Determinismo y predecibilidad no quieren decir lo mismo.

La especie del determinismo se despliega, por así decir, en dos subespecies. Una, matemática. Otra, física. Vayamos con la matemática. El determinismo en sentido matemático presenta, a su vez, dos acepciones. Por una parte, lo que llamo determinismo diferencial: un proceso es determinista si y sólo si presenta una dinámica diferencial, esto es, puede ser modelizado correctamente mediante una ecuación diferencial o en derivadas parciales. Esta definición está, como tal, en Bertrand Russell, Boris Hessen y René Thom. Por otra parte, lo que llamo determinismo único: un proceso es determinista si y sólo si presenta una evolución única, esto es, si el sistema atraviesa en dos instantes distintos un mismo estado, las evoluciones posteriores coinciden (a unas mismas condiciones iniciales, una misma historia). Ahora, ¿qué relación existe entre el determinismo diferencial y el determinismo único? Pues bien, el determinismo diferencial no implica necesariamente el determinismo único. Existen sistemas dinámicos dados por ecuaciones diferenciales ordinarias sin unicidad de solución. En otras palabras, como ocurre en Mecánica Cuántica, dos sistemas pueden estar idénticamente preparados y evolucionar de modo diferente cada uno. Si lo visualizamos en el espacio de fases o de estados, esta situación se corresponde con la bifurcación o escisión de una trayectoria. Sin embargo, pese a que requiere artillería matemática pesada para probarlo, el determinismo único sí implica el determinismo diferencial. En efecto, como demostró Hassler Whitney en la década de los 30, si disponemos de un manojo de trayectorias en el espacio de fases que no se cortan entre sí (o, con más precisión, las únicas trayectorias que se cortan son las periódicas), es decir, sin escisiones o bifurcaciones, resulta en principio posible definir localmente bajo condiciones muy generales una ecuación diferencial que las defina. Es lo que los físicos llevan haciendo toda la vida: conocidas las curvas integrales que se nos dan en la empiria, determinamos el campo.

Y con respecto al determinismo en sentido físico, hay que decir que fue formulado como tal por Bohr y Heisenberg, y no refiere tanto a las condiciones que ha de reunir el proceso sino el estado del sistema para ser determinista. Si el determinismo en sentido matemático se fija en cómo transcurre un sistema determinista, el determinismo en sentido físico se centra más bien en cómo tiene que venir dado: un sistema es determinista si y sólo si todos sus observables físicos están siempre bien definidos. Esto tiene que ver, naturalmente, con las relaciones de indeterminación de la Mecánica Cuántica.

Así pues, a mi juicio, cabe hablar perfectamente de distintos grados de determinismo, según se den en un sistema todas o sólo una de las condiciones antes señaladas. Hay determinismos fuertes y débiles.

En relación al concepto epistemológico de predecibilidad, hay que señalar que si nuestro sistema es, desde una perspectiva ontológica, determinista y estable, tenemos garantizada la predecibilidad. Y si además es reversible, logramos la bipredecibilidad, esto es, la predicción y la retrodicción.

3. Con esto a mano, estamos en condiciones de iniciar nuestro acercamiento a la Teoría del Caos (1890-1980). Arrojemos luz sobre la prehistoria del caos determinista. La Mecánica Clásica entronizó la idea de que enunciar una ley física consiste en formular una ecuación diferencial lineal o... ¡no lineal! (como en el problema de los n cuerpos). Para n = 2, el problema fue resuelto, geométricamente, por Newton y, analíticamente, por Euler. Sin embargo, para n = 3 ó n > 3, el problema de los tres cuerpos, íntimamente relacionado con la cuestión de la estabilidad del Sistema Solar, se les resistió. Newton, atisbando su gran complejidad, llegó a vislumbrar la Mano de Dios tras él. En cambio, en su Sistema del Mundo, Laplace creyó, equivocadamente, resolverlo. Tiempo después, en 1885, Poincaré llegó a ofrecer otra resolución en falso. Pero rectificar es de sabios. Y en 1890, alarmado ante la complejidad de lo que hoy denominamos una órbita homoclínica, Poincaré alumbró un estudio cualitativo/topológico (no meramente cuantitativo ó métrico) de este problema y, en general, de toda ecuación diferencial no lineal, centrándose en el estudio de la estabilidad de las trayectorias. Por todo esto, muchas veces se considera a Poincaré como el abuelo de la Teoría del Caos.

Henri Poincaré & Edward Lorenz

Pero hubo que esperar más de medio siglo para que las ideas de Poincaré tuvieran continuación. La historia propiamente dicha de la Teoría del Caos comienza en 1963, cuando Edward Lorenz se convierte en su verdadero padre, al redescubrir el caos determinista con ayuda de una computadora. Estudiando un flujo determinista no periódico e inestable, Lorenz descubrió el célebre atractor que lleva su nombre (y cuyo carácter de atractor, pese a que se haya dado comúnmente por supuesto, no ha sido demostrado hasta 2002). Años después, Lorenz acuñaría la célebre metáfora del «efecto mariposa». Pero sería el matemático norteamericano Guckenheimer quien, en 1973, hablara por vez primera de «dependencia sensible a las condiciones iniciales». Paralelamente, a lo largo de los 60, Stephen Smale daría con su famosa herradura, que pasa por ser el paradigma de los efectos de transitividad topológica que llevan al caos. Y sería James Yorke quien, en 1975, introdujera el término «caos» en la literatura científica.

A día de hoy, el caos determinista pasa por ser la conjugación de dos efectos. Por un lado, del efecto mariposa (o dependencia sensible a las condiciones iniciales). Por otro lado, atención, tomando prestada una denominación debida a Rañada, del efecto baraja, es decir, de la mezcla topológica. Pese a lo que afirmen importantes filósofos de la ciencia de la corriente analítica (excuso decir nombres), no basta con el efecto mariposa: un sistema dinámico que venga dado por una ecuación diferencial sencilla cuyas trayectorias solución sean exponenciales presenta dependencia sensible a las condiciones iniciales, pero allí no hay nada complejo o extraño. Hace falta el confinamiento de las trayectorias. El caos no consiste sólo en que las trayectorias se separen, sino también en que luego vuelvan sobre sí mismas dando lugar a configuraciones verdaderamente caóticas. Y, ¿en qué clase de sistemas cabe esperar dinámicas caóticas? En primer lugar, en sistemas no lineales y no integrables. Y, dentro de ellos, hay que apuntar que se da un caos en sentido impropio en los sistemas hamiltonianos o conservativos (porque, aunque estos sistemas, como el de los tres cuerpos, pueden dar lugar a un comportamiento nada regular, jamás presentan atractores, por el Teorema de Liouville) y se da un caos en sentido propio o genuino en los sistemas no hamiltonianos o disispativos (porque estos sistemas pueden, al no conservar la energía, presentar atractores, como el sistema de Lorenz, dando lugar a comportamientos muy irregulares).

4. Y, ahora, de vuelta a la filosofía de la ciencia, para construir un argumento contra la concepción instrumentalista de la física. Para el instrumentalismo, la predecibilidad es una condición necesaria y (casi) suficiente de las teorías científicas: cientificidad = predecibilidad. La predicción es, desde el enfoque instrumentalista, parte de la esencia o definición de la ciencia. Para Duhem, por ejemplo, una teoría física no era más que un conjunto de ecuaciones con probada capacidad predictiva. Idea que los positivistas del Círculo de Viena recogieron, y que sigue muy viva en neopositivistas como Van Fraassen y en pragmatistas como Laudan. Este ultapredictivismo se manifiesta, incluso, en Rorty: «la predicción es una condición necesaria para estar en la caja llamada ciencia».

Lo que demarca a una teoría científica de una no-científica no es sólo que haga predicciones, sino que hace predicciones correctas. Ahora bien... el carácter científico de la Teoría del Caos es innegable (al menos desde una perspectiva sociológica) y, sin embargo, la predecibilidad de los sistemas caóticos brilla (al parecer) por su ausencia. ¿Cómo solventar esta incompatibilidad entre la Teoría del Caos y el instrumentalismo? Pero, ¿no afectará también al realismo? ¿Es el caos una amenaza para la concepción clásica de las teorías científicas?

En general, por decirlo parafraseando a Schopenhauer, la cuádruple raíz del problema de la predicción tiene que ver con (i) la excesiva simplicidad en las ecuaciones del modelo, (ii) la imperfección en las constantes del modelo, (iii) la inexactitud en la medida de las condiciones iniciales y (iv) la imprecisión en los métodos de cómputo. El caos implica que los errores (iii) y (iv) se inflarán espectacularmente, de modo que la trayectoria real y la trayectoria predicha divergirán notablemente a medio o largo plazo. Empleando palabras de Poincaré: «La predicción deviene imposible».

Una ilustración de rabiosa actualidad nos la proporciona el Cambio Climático. El propio Lorenz ya había dejado escrito, en su artículo seminal, con respecto a la predicción del tiempo meteorológico lo siguiente: «Dos estados que difieran imperceptiblemente pueden evolucionar a dos estados considerablemente distintos. Si hay cualquier error en la observación del estado presente –y en un sistema real parece inevitable–, una predicción aceptable del estado en el futuro bien puede ser imposible». Y recientemente, el Panel Intergubernamental para el Cambio Climático, que prefiere usar el término proyección al de predicción, ha advertido que «en la investigación y creación de modelos climáticos debemos reconocer que nos enfrentamos con un sistema caótico y, por tanto, las predicciones de los estados climáticos futuros no son posibles». De hecho, Freeman Dyson, uno de los grandes físicos del siglo XX, ha llegado a decir: «Los modelos climáticos son, esencialmente, herramientas para comprender el clima, que todavía no son adecuadas para predecirlo, no hay que creerse los números sólo porque salen de una supercomputadora».

Pero, atención, el balance predictivo de los sistemas caóticos puede ser –frente a los que nos han hecho creer los divulgadores del caos posmoderno (y estoy pensando en aquellos a quienes Sokal y Bricmont señalan con el dedo, es decir, Deleuze, Guattari, Lyotard... y, entre nosotros, un poco, Antonio Escohotado)– exitoso a corto plazo e, incluso, positivo de un modo no cuantitativo sino cualitativo, topológico (me refiero, por ejemplo, al cálculo de invariantes topológicos en la Teoría de los Sistemas Dinámicos). De todas formas, aunque sí que proporciona predicciones (a corto plazo y, sobre todo, cualitativas o topológicas), la revolucionaria Teoría del Caos no lo hace –ni puede hacerlo– de modo suficientemente rico, a la manera de la Teoría de la Relatividad o de la Teoría Cuántica.

Bien, para el instrumentalista, el poder predictivo es la pieza clave de la consolidación de las teorías científicas; pero, entonces, como se preguntan Peter Smith o Stephen Kellert: «¿Es realmente la Teoría del Caos una teoría científica?». Desde luego, esta pregunta también puede hacérsele al realista, pero éste tiene más fácil contestarla: «una teoría científica –dirá– puede no gozar de éxito predictivo y no por ello tener que ser abandonada, ya que puede ser verosímil (i. e., según Niiniluoto, aproximadamente verdadera y con un alto contenido informativo)». La predicción puede fallar y todavía quedar la verdad, porque para el realista –a diferencia del instrumentalista– la ciencia no sólo produce predicciones, versa también sobre la naturaleza de las cosas. Para el realista, el éxito implica la verdad (inferencia de la mejor explicación); pero la verdad no implica necesariamente el éxito, porque éste depende de múltiples factores añadidos (prácticos, tecnológicos, &c.). Por consiguiente, la Teoría del Caos no será exitosa; pero es verosímil, y el indicador de esta verosimilitud –replicará el realista común– es que es explicativa a posteriori, ex post facto (de otra manera, nos explica precisamente por qué no podemos predecir).

Sin embargo, al rechazar la verdad de las teorías y considerar el éxito como un dato último, el instrumentalista pasa por problemas para defender que una teoría sin éxito predictivo como la Teoría del Caos pueda ser una buena teoría. Un ejemplo: desde el empirismo constructivo de Van Fraassen, la Teoría del Caos no es aceptable, puesto que no es empíricamente adecuada. En efecto, de acuerdo con Van Fraassen, «el propósito de la ciencia es ofrecernos teorías empíricamente adecuadas y su aceptación sólo implica la creencia de que lo son». Una teoría es –según Van Fraassen– un conjunto de modelos, y un modelo es una trayectoria en el espacio de fases o de estados del sistema dinámico. La adecuación empírica se define, entonces, por la isomorfía (en el sentido de identidad entre estructuras) entre la trayectoria del modelo y la trayectoria aparente o fenoménica.

Consideremos un sistema dinámico caótico, ¿son isomorfas la trayectoria predicha por el modelo y la trayectoria real? No; porque, a causa de la inflación del inevitable error en las condiciones iniciales, ambas trayectorias no serán isomorfas (idénticas). Aún más: concediendo cualquier margen ε de error (con ε pequeño, para que la predicción no sea espuria), es posible encontrar –aplicando la definición matemática de caos– trayectorias que salen de un ε-entorno y acaban distando entre sí más de ε (¡ni siquiera ε-isomorfas ó ε-homeomorfas!). Para fijar ideas: si estamos interesados en la evolución del sistema logístico de May F(x) = 4x(1-x) para el dato inicial real a = 0.900 y para el dato inicial medido b = 0.901 (hemos cometido un error del orden de una milésima), observaremos cómo las órbitas de a y de b terminan por alejarse sensiblemente pese a estar inicialmente próximas. En efecto, por recurrencia obtenemos que tras siete iteraciones a se ha transformado en 0.9708 y b, en 0.9958. ¡¡El error se ha multiplicado por 20 en tan solo 7 iteraciones!!

Gráfico de Lorenz que ilustra la separación

de dos trayectorias inicialmente muy próximas

La adecuación empírica que Van Fraassen exige a las teorías científicas es una característica que sólo es predicable de las que son –como dice René Thom– estructuralmente estables. Ya en La teoría física, Duhem se dio cuenta de que el descubrimiento de Poincaré y Hadamard era «un ejemplo de deducción matemática que para el físico es una predicción inutilizable»; y, a fin de garantizar predicciones de calidad, exigía estabilidad al dominio de la teoría. Como la Teoría del Caos no cumple el requisito de estabilidad estructural, no es empíricamente adecuada; y, por tanto, Van Fraassen debe concluir que no es aceptable y, sin embargo, lo es, porque es la mejor posible. A veces, el objetivo de los científicos no es ni puede ser construir modelos empíricamente adecuados.

Todo esto nos lleva a un callejón sin salida. La comprensión de la Teoría del Caos supone una traba al instrumentalismo a la manera que lo es la de la Astronomía para buena parte del realismo. Los modelos construidos con ayuda de la Teoría del Caos no son instrumentos para la predicción, porque sacrifican la meta predictiva en aras de la meta explicativa. Hay que elegir: o bien un modelo preciso para predecir, o bien una extrema simplificación para comprender.

5. Realismo sin metafísica, instrumentalismo sin relativismo

1. ¿Qué conclusiones generales cabe establecer después de nuestros dos casos de estudio? A nuestro juicio, una fundamental bien puede ser la siguiente, a saber: el debate contemporáneo acerca del realismo científico está infectado de una metafísica intratable a causa del uso indiscriminado de términos tales como teoría, representación o predicción. Sin embargo, si pasamos de la teoría a la práctica, de la Academia al Laboratorio, que es donde se produce ciencia, el antirrealismo tiene mucha menos fuerza...

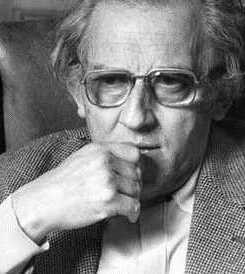

Gustavo Bueno & Ian Hacking

2. Postulo que es posible un realismo no estándar, un realismo que se coloque más allá de la representación y la predicción, centrándose en la experimentación. Y reconozco como ejemplo el realismo «materialista» del nuevo experimentalismo de Ian Hacking y de la teoría del cierre categoríal de Gustavo Bueno, ampliamente desarrollados en el último capítulo de la tesis. Estos dos filósofos marcan un nuevo rumbo en filosofía de la ciencia: «los filósofos de la ciencia se han limitado a pensar la ciencia como representación o predicción, pero de lo que se trata es de pensarla como transformación (construcción e intervención)». En cualquier caso, de cara al futuro, no cabe sino reconocer que la mayor o menor potencia de una teoría de la ciencia se va a medir por su capacidad para estar al tanto del funcionamiento de las ciencias modernas, como la física cuántica o la física del caos... Muchas gracias.

LHC del CERN

6. Resumen del debate posterior: a vueltas con el materialismo filosófico

1. Dentro del turno de preguntas, intervino en primer lugar la Prof. Ana Rioja. Tras felicitar al doctorando y al director de la tesis por el minucioso trabajo realizado, la Prof. Rioja formuló dos preguntas. En primer lugar, centrándose en el primer caso de estudio, el relativo a la equivalencia matemática entre Mecánicas Cuánticas, planteó que a lo largo de los tres capítulos se desprende una tesis muy radical: que las matemáticas determinan la ontología, o dicho de otra manera, que el formalismo condiciona la interpretación, cuando en física se trata de dos cosas diferentes. Por ejemplo, apuntó la Prof. Rioja, la incompatibilidad ontológica entre la Mecánica Matricial y la Mecánica Ondulatoria desaparece cuando asumimos la interpretación onda-partícula de De Broglie. Y, en segundo lugar, atendiendo al último capítulo de la tesis, la Prof. Rioja planteó cómo encajaba su contenido dentro de la estructura global de la tesis.

Con respecto a la primera cuestión, el doctorando respondió que la tesis de que la matemática condiciona la ontología física es una tesis que él sostiene de arriba abajo, y que, pese a la idea de Heisenberg de que son dos cosas separadas, los ejemplos en contra abundan. Las matemáticas no son neutras ontológicamente; porque, por ejemplo, en la Mecánica de Feynman es la herramienta matemática conocida como integral de camino lo que posibilita la interpretación como suma de historias, o en la Mecánica de Bohm es la propiedad matemática de autonomía de la ecuación de puntos-guía aquello que posibilita la interpretación determinista y realista. Además, retomando el ejemplo de la Prof. Rioja, cabe decir que lo que posibilita la interpretación de De Broglie que borra la contradicción ontológica entre ondas y partículas es, precisamente, la teoría matemática de la doble solución. Cambia la interpretación, porque cambia el formalismo. Existe una carga ontológica de las matemáticas, porque las matemáticas que usamos para hacer física no son neutras ontológicamente. Y, con respecto a la segunda cuestión, el doctorando señaló que la Teoría del Cierre Categorial de Gustavo Bueno o el Nuevo Experimentalismo de Ian Hacking, con su común interés por los aparatos, habían sido para él algo así como la luz al final de túnel, la posibilidad de seguir defendiendo el realismo científico sin necesidad de asumir el pesado bagaje metafísico de los representacionalistas.

2. A continuación, en segundo lugar, intervino el Prof. Miguel Ferrero. Tras señalar que conocía de primera mano los trabajos del doctorando en El Catoblepas o el muy reciente en El Basilisco, a propósito de la aplicación de la teoría del cierre a la Mecánica Cuántica, así como que había reseñado un artículo suyo para Mathematical Reviews, el Prof. Ferrero avisó que tenía 11 páginas de comentarios, críticas y objeciones a la tesis, clasificados en cuatro partes.

Primera parte. Con respecto a la presentación que el doctorando hace del realismo científico, el Prof. Ferrero señaló que le parecía excesivamente grosera y simplificadora, por cuanto –por ejemplo– él se consideraba realista científico, creía en el progreso científico (realismo progresivo), pero a la vez rechazaba el realismo de teorías y de entidades (porque no sabemos bien cuál es la naturaleza de lo que da vueltas dentro de un acelerador de partículas) y, sin embargo, esa posibilidad no quedaba recogida en ningún momento en los análisis del doctorando (por cuanto, desde las coordenadas de la tesis, el realismo de progreso implica el de teorías y entidades). En su defensa, el doctorando planteó que no veía cómo compaginar la defensa del progreso científico en sentido realista con, simultáneamente, un fuerte antirrealismo con respecto a los electrones, positrones, neutrinos... En otras palabras: a lo mejor, el realismo del Prof. Ferrero, a la manera del de Andrew Pickering y otros sociólogos de la ciencia, no tenía de realismo más que el nombre. El Prof. Ferrero aclaró que había ofrecido, en diversos artículos publicados en revistas internacionales, una definición de progreso tal y como se entiende en física, es decir, según explicó, como la confluencia entre diversos cursos de investigación independientes, y lo ejemplificó con la coincidencia en el valor de la constante de Planck que ofrecen teorías independientes. El doctorando señaló que ese punto de vista presentaba notable similitud con la teoría de la identidad sintética del Prof. Gustavo Bueno, y que éste último la había ilustrado con un ejemplo análogo relativo al cálculo de la constante de Rydberg en 1982. El Prof. Ferrero contestó que él cuando escuchaba el término «identidad sintética» no sabía lo que se quería decir.

Segunda parte. Con respecto al primer caso de estudio, el Prof. Ferrero comentó que él no veía nada en el trabajo del doctorando que fuera más allá de los trabajos de Muller sobre la equivalencia matemática entre Mecánicas Cuánticas de 1997. El doctorando señaló que su análisis y el de Muller eran muy diferentes y difícilmente podían ponerse en pie de igualdad; por cuanto, aunque hablan de lo mismo, el doctorando y Muller lo hacen de dos modos por completo distintos, llegando a conclusiones distintas. Muller habla de un Mito de la Equivalencia y niega que las Mecánicas Matricial y Ondulatoria fueran empíricamente equivalentes en 1926, mientras que el doctorando defiende –con los físicos del momento– la equivalencia empírica entre ambas y postula –con los matemáticos de la época– la equivalencia matemática como explicación de la equivalencia empírica, aparte de que Muller apenas arroja luz sobre el trasfondo gnoseológico del Análisis Funcional, cuyo desarrollo fue vital para alcanzar la prueba de Von Neumann (por ilustrarlo: Muller adjudica a Schmidt la construcción del espacio de sucesiones de cuadrado sumable –el llamado «ele-dos-chica», substrato de la Mecánica de Matrices– en 1927, pero este espacio había aparecido ya en los trabajos de Hilbert sobre ecuaciones integrales de 1905). Además, el enfoque de Muller es semántico (estructuralista), mientras que el enfoque del doctorando es sintáctico (apoyándose en la teoría del cierre categorial). A propósito de lo cual, el Prof. Ferrero terció que, cuando veía los cuadros sobre los espacios gnoseológicos de la Mecánica Matricial o de la Mecánica Ondulatoria, no entendía prácticamente nada... ¿qué es un fenómeno o una esencia? ¿Por qué esto es un autologismo y aquello un dialogismo? La clasificación era –sentenció– totalmente arbitraria. El doctorando contestó que si por arbitrario se entendía que eran posibles otras clasificaciones, por supuesto que los cuadros eran arbitrarios, porque toman partido por una determinada cartografía o mapa conceptual muy particular. Ahora bien, continuó, la propia justificación de la utilidad de las herramientas del materialismo filosófico estaba in media re. Estas herramientas quedaban justificadas en marcha y sobre la marcha. Si la tesis había podido cerrarse, es porque precisamente las categorías utilizadas funcionaban dentro del análisis. A lo mejor, con otras, la tesis no habría pasado de la página 30. El Prof. Ferrero replicó que a la Física Cuántica le daba igual lo que dijera el Materialismo Filosófico. A lo que el doctorando respondió que, efectivamente, así tenía que ser: a los físicos cuánticos, cuando hacen ciencia, les da igual lo que digan los filósofos, porque ellos hacen ciencia, no filosofía; pero, cuando filosofan espontáneamente sobre su oficio, las cosas cambian diametralmente, y en eso estamos.

Tercera parte. Con respecto al segundo caso de estudio, el relativo a la Teoría del Caos, el Prof. Ferrero añadió que todo lo que el doctorando decía podía resumirse en las cuatro páginas que el Prof. Rañada escribiera hace años. Inmediatamente, el doctorando apuntó que su objetivo no era escribir un manual de Mecánica Clásica como el del Prof. Rañada, sino hacer filosofía de la ciencia, algo muy distinto. El Prof. Rañada y el doctorando estaban en dos pisos diferentes, porque la física es un saber de primer grado y la filosofía, de segundo grado. Y lo original de la tesis radicaba en el análisis histórico y filosófico del caos determinista, en particular de las relaciones entre el determinismo y la predecibilidad, no siempre bien diferenciadas por los epistemólogos analíticos (por ejemplo, hace algunos años, en Analysis, Hunt venía a negar que los fenómenos con caos determinista fueran predecibles a tiempos cortos, o, más recientemente, en la Enciclopedia Stanford de Filosofía, Hoefer asociaba erróneamente el determinismo con la reversibilidad, olvidándose de la ecuación del calor, que es determinista pero irreversible). A continuación, el Prof Ferrero indicó que quería llamar la atención sobre varios errores importantes. Por ejemplo, en la página 112 de la tesis, se decía que las innovadoras consecuencias de la introducción del cuanto de acción se estaban conociendo en 1911 (cuando la cuantificación de Planck es de 1900), o, también, en la página 174, se decía que Newton lo calculaba todo y no explicaba nada (cuando eso es un sinsentido). El doctorando aclaró que si uno leía desde el comienzo la frase a la que el Prof. Ferrero hacía referencia en la página 112, descubría que el sujeto de la oración era Poincaré, quien tomó contacto con la teoría cuántica precisamente en 1911, en el primer Congreso Solvay. Análogamente, si uno miraba el inicio del párrafo mentado de la página 174, notaba que se trataba de una cita de René Thom, quien tenía en mente el lema newtoniano hypotheses non fingo. A propósito de Newton, el Prof. Ferrero preguntó al doctorando que era para él la magia cuando afirmaba, varias páginas más adelante, que la acción a distancia newtoniana guardaba cierto tufillo de magia. A lo que el doctorando respondió que él se acogía a la definición de magia de La Rama Dorada de Fraser, en la que la magia se caracteriza por la acción a distancia, esto es, por todo lo contrario a la causalidad que observamos operando entre los cuerpos, que siempre obra por contigüidad. Sin embargo, el Prof. Ferrero señaló que eso no era así, porque los antiguos explicaban la acción mágica por mediación del éter... «¿El éter? ¡El éter! ¡Pues eso, la magia! Nada más mágico que el éter. Una pseudo-explicación», matizó el doctorando.

Cuarta parte. Finalmente, con respecto a esta última parte, el Prof. Ferrero avanzó que, aunque era políticamente incorrecto mencionar y citar a Gustavo Bueno, esta parte le había parecido la más sugerente de toda la tesis, pese a que tenía varias objeciones que plantear. En especial, contra aquella afirmación realizada siguiendo a Gustavo Bueno e Ian Hacking de que los aparatos e instrumentos no pueden cambiar de teorías... El doctorando subrayó que pese a que la idea que nos forjamos de su funcionamiento está mediada por los conceptos de las teorías científicas, aquél es independiente de éstas, como también lo subraya Kuhn en La estructura de las revoluciones científicas. Servía como ilustración el hecho de que, tal vez, en el futuro, prescindamos de la teoría de los quarks y la sustituyamos por otra que también verse sobre la constitución atómica de la materia; pero que, pasara lo que pasara, si en ese instante, sobre el salón de grados, explotaba una bomba atómica, el resultado es y sería siempre idéntico. El Prof. Boya aprovechó la ocasión y terció que, curiosamente, esto era lo que siempre le dijo Popper a Bohr: que él era realista por Hiroshima.{1}

3. Tras el largo debate con el Prof. Ferrero, tomó la palabra el Prof. Diéguez. Tras remarcar que nos encontrábamos ante una tesis muy seria, que venía refrendada por publicaciones en revistas importantes, subrayó que algunos capítulos –el dedicado al realismo estructural especialmente– debían dan lugar a alguna publicación de carácter internacional. Entre otras cuestiones, el Prof. Diéguez comentó que la discusión de las tesis del realismo científico era, en algunos momentos, demasiado férrea, por cuanto el realismo de entidades quedaría mejor definido si sólo se pidiera que las entidades teóricas poseyeran referente, algo que no compromete a tanto, y que permitiría distinguir mejor entre los realismos de Giere, Niiniluoto y Bunge o entre los antirrealismos de Laudan, Van Fraassen y Kuhn (ese kantiano postdarwinista). Después, el Prof. Diéguez planteó que el doctorando asumía que, para el realista científico, el éxito implicaba la verdad (inferencia de la mejor explicación), pero que el tema era mucho más sutil: si escuchamos ruidos en la cocina y al día siguiente el queso aparece mordisqueado, lo natural es pensar que tenemos un ratón en casa; pero eso no quiere decir que siempre que oigamos ruido y falte queso, haya un ratón en casa. Además, el Prof. Diéguez apuntó que no compartía el antirrepresentacionalismo de signo casi rortiano de que hacía gala el doctorando: resulta difícil negar que, por el mero hecho de faltarnos la propiedad de enfrentabilidad, una célula no sea observable, cuando un microscopio no es, en el fondo, sino una lupa ampliada. El doctorando remarcó que la escala corporal era el primer analogado y el origen obligado de todos los análisis y que, sin lupa o microscopio, yo no percibo una célula. Pero, entonces, replicó el Prof. Diéguez, ese argumento también sería válido contra una persona que lleve gafas gruesas y no vea bien cierto cuerpo. El doctorando matizó que la diferencia estaba en que el ciego podía tocar con sus manos ese cuerpo, pero nunca una célula (siempre «tocamos» tejidos). A lo que el Prof. Diéguez respondió que, a día de hoy, sí somos capaces de tocar una célula, como demuestra la fecundación in vitro de un óvulo con un único espermatozoide portado en una aguja. Sin embargo, terció el doctorando, en ese caso ya se está presuponiendo la imprescindible mediación de los aparatos, de la aguja, y vuelta a empezar. Por último, el Prof. Diéguez se preguntó si realmente la teoría cuántica es definitiva contra el realismo. Contra el realismo estructural, desde luego. Contra otros realismos, como el experimental o el materialista, ni mucho menos. Los aparatos de Rutherford o Millikan demuestran directamente, enfatizó el doctorando, la realidad de las partículas alfa o de los electrones. A lo que el Prof. Boya añadió que, como sostenía el propio Rutherford frente a Mach, el físico no era un coleccionista de sellos.

4. En cuarto lugar, intervino el Prof. Boya. Antes de nada, el Prof. Boya señaló que también le hubiera gustado leer en la tesis lo que el doctorando tuviera que decir sobre el problema del realismo tal y como se plantea dentro de la Mecánica Cuántica. A lo que el doctorando añadió que su aproximación al debate sobre el realismo científico era más genérica (a las diversas ciencias: física, química...) que específica (a la física cuántica, dejando de lado el problema de la interpretación realista o determinista). Con respecto al tema de la equivalencia entre la Mecánica Lagrangiana y la Mecánica Hamiltoniana, el Prof. Boya precisó que dependía de ciertas condiciones de invertibilidad. Y, por su parte, con respecto a la equivalencia entre la Mecánica Matricial y la Mecánica Ondulatoria, dejó constancia de las interesantes discusiones que había mantenido con el doctorando (primero, por carta y, después, cara a cara), de las que había extraído la idea de que Dirac quedaba enmarcado dentro del contexto de descubrimiento de la equivalencia, mientras que Von Neumann lo hacía dentro del de justificación, estando ambos –como a continuación señaló el doctorando– mutuamente necesitados: sin Dirac, Von Neumann no habría tenido nada que demostrar; pero, recíprocamente, sin Von Neumann, Dirac o Schrödinger no habrían pasado a la historia como verdaderos descubridores de la equivalencia (pues podría haberles sucedido algo similar a lo que le pasó a Schiaparelli con su «descubrimiento» de los canales de Marte). Entre otros comentarios, el Prof. Boya subrayó que el doctorando acertaba al afirmar que el famoso libro de Von Neumann sobre los fundamentos matemáticos de la cuántica había sido traducido al español antes que al inglés, algo análogo a lo que también había pasado con el libro al respecto de Schwartz, quedase esto dicho para la defensa del idioma patrio. Por último, el Prof. Boya inquirió al doctorando por la definición matemática de caos. El doctorando explicó que existen múltiples (la casi canónica de Devaney, la que emplea los exponentes de Lyapunov, la que usa la entropía topológica, &c.) y que, sorprendentemente, no son del todo equivalentes, lo que constituye un problema para el definitivo cierre de la Teoría del Caos.

5. Al final, en quinto y último lugar, tomó la palabra el Prof. Bombal. Tras agradecer al director de la tesis (Andrés Rivadulla) la invitación a formar parte y presidir un Tribunal en Filosofía, advirtió que iba a centrarse en los aspectos más matemáticos de la tesis, sin extenderse demasiado dada la hora que era (el acto académico comenzó a las 12:00 y concluyó a las 16:05). Primeramente, el Prof. Bombal comentó que él creía que el tema de la equivalencia matemática estaba cerrado desde hace tiempo y no daba más de sí. El doctorando señaló que, paradójicamente, podía decirse que sí, que en efecto, que está cerrado; pero que no lo estaría tanto cuando los matemáticos adjudican la equivalencia a Von Neumann, los físicos a Dirac o Schrödinger, los filósofos e historiadores de la ciencia también a Eckart o Pauli, e incluso otros –como Ulises Moulines– niegan que haya equivalencia. En lo único en que todos parecen estar de acuerdo es en que la cuestión está (supuestamente) cerrada. En segundo lugar, el Prof. Bombal criticó que el análisis de las Mecánicas de Heisenberg-Born-Jordan y de Schrödinger lo llevara a cabo el doctorando con gafas de hoy día. A lo que el doctorando respondió que su propósito era hacer una reconstrucción histórica, a posteriori, armada con lo que hoy sabemos, a fin de arrojar la mayor luz posible, y no tanto contar o narrar cómo se vivieron los hechos. A continuación, en tercer y último lugar, el Prof. Bombal se centró en el estudio de la relación entre las matemáticas y la realidad. Insertándose en la tradición aristotélica que pasa por Ptolomeo, Osiander y Bellarmino hasta llegar a Steven Hawking, el Prof. Bombal sostuvo que las matemáticas no tienen nada que ver con el mundo real; y, por lo tanto, carece de sentido plantearse, como hace el doctorando en su argumento contra el realismo estructural, que la Mecánica Matricial o la Mecánica Ondulatoria puedan ser isomorfas a la estructura del mundo, lo que sólo tomaría sentido si «axiomatizamos» la realidad, labor imposible. A su juicio, esto restaba toda fuerza al argumento de la cardinalidad –discreto vs. continuo– contra el realismo estructural. El doctorando respondió que frente a la tradición instrumentalista mencionada existía otra, la realista, encabezada por Platón y que incluye nombres como el de Einstein. Pero que, en todo caso, su postura a lo largo de la tesis era la de simplemente defender que las estructuras matemáticas están cargadas ontológicamente. Una matemática discreta invita a una interpretación corpuscular. Una matemática continua sugiere una interpretación ondulatoria. Si hay una ecuación de ondas, tenemos que buscar las ondas, como decía Schrödinger. Y si cambia el formalismo, cambia la interpretación, así como recíprocamente (la interpretación estadística de la función de onda de Born, que pretende salvar la contradicción entre partículas y ondas, sólo pudo abrirse paso cuando se introdujeron espacios de probabilidad, medidas y σ-álgebras, en el formalismo). Finalmente, con relación a la «axiomatización de la realidad», esto es, la asunción de que el mundo posee una estructura matematizable, el doctorando explicó que, para formular su argumento contra el realismo estructural, él sólo se acogía al vocabulario («estructura», «isomorfismo», «homomorfismo», &c.) propio de los filósofos analíticos de la ciencia. De lo contrario, si no lo hacía, si negaba la mayor, nada habría que discutir.

6. Tras preguntar a los doctores asistentes entre el público si deseaban formular alguna otra pregunta, el Tribunal se retiró a deliberar. Vale.

A Mauricio Suárez, amigo de la verdad,

pero más amigo de Ánito.

Nota

{1} En la casi hora y media que consumió, el Prof. Ferreró formuló al doctorando muchas más preguntas, que omito por ser, a mi entender, cuestiones de detalle (por ejemplo, preguntó a propósito de la motivación para escribir sobre la equivalencia entre Mecánicas Cuánticas, por la relación de inclusión de la Teoría Atómica de Bohr dentro de las dos Mecánicas Cuánticas, por la distinta definición de hermiticidad que dan los físicos o damos los matemáticos, &c.).